NVIDIA a récidivé, mais cette fois avec une touche particulière : en semblant emprunter une page du manuel de jeu de la concurrence. Lors du NVIDIA GTC, qui est devenu l’un des événements les plus importants de l’industrie de l’IA, la société a annoncé la dernière itération de son architecture matérielle et de ses produits. Voici un aperçu des annonces et de ce qu’elles signifient pour l’écosystème dans son ensemble.

Hopper : la nouvelle architecture GPU de NVIDIA

GTC, qui a débuté lundi et se poursuivra jusqu’à jeudi, propose plus de 900 sessions. Plus de 200 000 développeurs, chercheurs et data scientists de plus de 50 pays se sont inscrits à l’événement. Lors de sa GTC 2022 discours d’ouverturele fondateur et PDG de NVIDIA, Jensen Huang, a annoncé une multitude de nouvelles dans les domaines des centres de données et du calcul haute performance, de l’IA, de la collaboration en matière de conception et des jumeaux numériques, des réseaux, de l’automobile, de la robotique et de la santé.

Le cadre de Huang était que « les entreprises traitent, affinent leurs données, créent des logiciels d’IA… deviennent des fabricants de renseignements ». Si l’objectif est de transformer les centres de données en « usines d’IA », comme le dit NVIDIA, il est logique de placer les transformateurs au cœur de cette démarche.

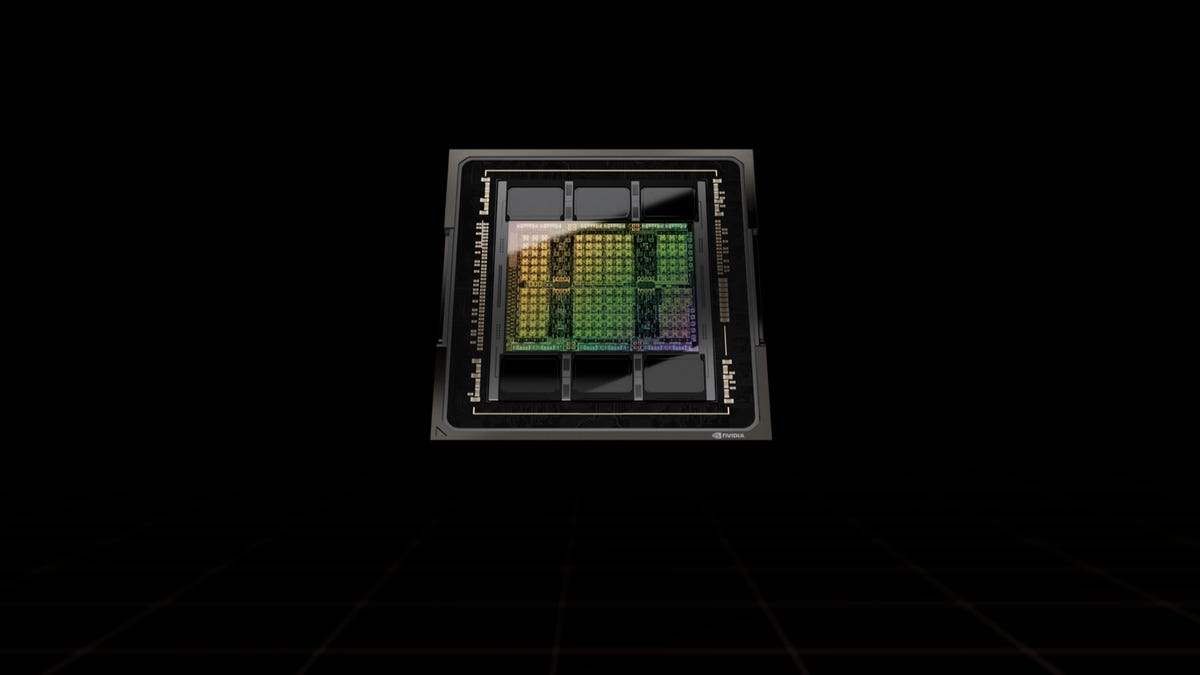

Le point central des annonces a été la nouvelle architecture GPU Hopper, que NVIDIA qualifie de « nouvelle génération de calcul accéléré ». Nommée en l’honneur de Grace Hopper, une informaticienne américaine pionnière, la nouvelle architecture succède à l’architecture NVIDIA Ampere, lancée il y a deux ans. La société a également annoncé son premier GPU basé sur Hopper, le Nvidia H100.

NVIDIA affirme que Hopper apporte un saut de performance d’un ordre de grandeur par rapport à son prédécesseur, et cet exploit repose sur six innovations révolutionnaires. Passons-les en revue, en prenant des notes rapides sur leur comparaison avec la concurrence.

Premièrement, la fabrication. Construit avec 80 milliards de transistors à l’aide d’un processus TSMC 4N de pointe conçu pour les besoins de calcul accélérés de NVIDIA, le H100 présente des avancées majeures pour accélérer l’IA, le HPC, la bande passante mémoire, l’interconnexion et la communication, y compris près de 5 téraoctets par seconde de connectivité externe. Au niveau manufacturier, les nouveaux arrivants tels que Cérébraux ou Graphcore ont également repoussé les limites de ce qui est possible.

Le GPU NVIDIA H100, le premier à utiliser la nouvelle architecture Hopper Nvidia

Deuxièmement, le GPU multi-instance (MIG). La technologie MIG permet de partitionner un seul GPU en sept instances plus petites et entièrement isolées pour gérer différents types de tâches. L’architecture Hopper étend les capacités MIG jusqu’à 7 fois par rapport à la génération précédente en offrant des configurations mutualisées sécurisées dans des environnements cloud sur chaque instance GPU. Run:AI, partenaire de NVIDIA, propose quelque chose de similaire comme couche logiciellesous le nom de partage GPU fractionné.

Troisièmement, l’informatique confidentielle. NVIDIA affirme que le H100 est le premier accélérateur au monde doté de capacités informatiques confidentielles pour protéger les modèles d’IA et les données des clients pendant leur traitement. Les clients peuvent également appliquer l’informatique confidentielle à apprentissage fédéré pour les secteurs sensibles à la confidentialité comme les soins de santé et les services financiers, ainsi que sur les infrastructures cloud partagées. Ce n’est pas une fonctionnalité que nous avons vue ailleurs.

Quatrième, NVIDIA NVLink de 4e génération. Pour accélérer les plus grands modèles d’IA, NVLink s’associe à un nouveau commutateur NVLink externe pour étendre NVLink en tant que réseau évolutif au-delà du serveur, connectant jusqu’à 256 GPU H100 à une bande passante 9 fois supérieure à celle de la génération précédente utilisant NVIDIA HDR Quantum InfiniBand. Encore une fois, cela est spécifique à NVIDIA, même si les concurrents exploitent souvent leur propre infrastructure spécialisée pour connecter également leur matériel.

Cinquièmement, des instructions DPX pour accélérer la programmation dynamique. La programmation dynamique est à la fois une méthode d’optimisation mathématique et une méthode de programmation informatique, initialement développée dans les années 1950. En termes d’optimisation mathématique, la programmation dynamique fait généralement référence à la simplification d’une décision en la décomposant en une séquence d’étapes de décision au fil du temps. La programmation dynamique est principalement une optimisation par rapport à la simple récursion.

NVIDIA note que la programmation dynamique est utilisée dans un large éventail d’algorithmes, y compris l’optimisation des itinéraires et la génomique, et qu’elle peut accélérer l’exécution jusqu’à 40 fois par rapport aux processeurs et jusqu’à 7 fois par rapport aux GPU de la génération précédente. Nous ne connaissons pas d’équivalent direct chez la concurrence, bien que de nombreux nouveaux venus dans le domaine des puces IA exploitent également le parallélisme.

La sixième innovation est celle qui nous semble la plus importante : un nouveau moteur de transformateur. Comme le note NVIDIA, les transformateurs constituent le choix de modèle standard pour le traitement du langage naturel et l’un des modèles d’apprentissage en profondeur les plus importants jamais inventés. Le Transformer Engine de l’accélérateur H100 est conçu pour accélérer ces réseaux jusqu’à 6 fois par rapport à la génération précédente sans perte de précision. Cela mérite une analyse plus approfondie.

Le moteur transformateur au cœur de Hopper

En regardant le titre du nouveau moteur de transformateur au cœur du H100 de NVIDIA, cela nous a rappelé Remarques de l’architecte Intel Raja M. Koduri à Tiernan Ray de ZDNet. Koduri a noté que l’accélération des multiplications matricielles est désormais une mesure essentielle des performances et de l’efficacité des puces, ce qui signifie que chaque puce sera un processeur de réseau neuronal.

Koduri était sur place bien sûr. Outre les propres efforts d’Intel, c’est ce qui a donné naissance à une nouvelle génération de conceptions de puces IA provenant d’un large éventail de nouveaux arrivants. Voir NVIDIA évoquer un moteur de transformateur nous a amené à nous demander si l’entreprise avait procédé à une refonte radicale de ses GPU. Après tout, les GPU n’étaient pas conçus à l’origine pour les charges de travail d’IA, ils s’avèrent simplement bons dans ce domaine, et NVIDIA a eu la clairvoyance et la perspicacité nécessaires pour construire un écosystème autour d’eux.

Aller plus profondément dans Analyse par NVIDIA de l’architecture HopperCependant, l’idée d’une refonte radicale semble s’être dissipée. Bien que Hopper présente un nouveau multiprocesseur de streaming (SM) avec de nombreuses améliorations en termes de performances et d’efficacité, cela ne va pas plus loin. Ce n’est pas surprenant, étant donné le poids de l’écosystème construit autour des GPU NVIDIA et les mises à jour massives et les incompatibilités potentielles qu’entraînerait une refonte radicale.

En décomposant les améliorations apportées à Hopper, la mémoire semble en être une grande partie. En tant que chef de produit Facebook pour PyTorch, la populaire bibliothèque de formation en apprentissage automatique, dit ZDNet, « Les modèles ne cessent de devenir de plus en plus gros, ils sont vraiment très gros et très coûteux à former. » De nos jours, les plus gros modèles ne peuvent souvent pas être entièrement stockés dans les circuits mémoire qui accompagnent un GPU. Hopper est livré avec une mémoire plus rapide, plus abondante et partagée entre les SM.

Un autre avantage vient des nouveaux cœurs tenseurs de quatrième génération de NVIDIA, qui sont jusqu’à 6 fois plus rapides d’une puce à l’autre par rapport à l’A100. Les noyaux tenseurs sont précisément ce qui est utilisé pour les multiplications matricielles. Dans H100, un nouveau type de données FP8 est utilisé, ce qui entraîne un calcul 4 fois plus rapide par rapport aux options à virgule flottante 16 bits de la génération précédente. Sur des types de données équivalents, il y a toujours une accélération 2x.

Résumé de l’amélioration du calcul H100 Nvidia

Quant au soi-disant « nouveau moteur de transformateur », il s’avère que c’est le terme que NVIDIA utilise pour désigner « une combinaison de logiciels et de la technologie NVIDIA Hopper Tensor Core personnalisée conçue spécifiquement pour accélérer la formation et l’inférence des modèles de transformateur ».

NVIDIA note que le moteur de transformation gère intelligemment et choisit dynamiquement entre les calculs FP8 et 16 bits, gérant automatiquement la refonte et la mise à l’échelle entre FP8 et 16 bits dans chaque couche pour offrir une formation IA jusqu’à 9 fois plus rapide et une inférence IA jusqu’à 30 fois plus rapide. accélérations sur les grands modèles de langage par rapport à la génération précédente A100.

Ainsi, même s’il ne s’agit pas d’une refonte radicale, la combinaison des améliorations de performances et d’efficacité entraîne une accélération 6x par rapport à Ampère, comme l’explique le blog technique de NVIDIA. L’accent mis par NVIDIA sur l’amélioration des performances des modèles de transformateurs n’est pas du tout déplacé.

Les modèles de transformateur constituent l’épine dorsale des modèles de langage largement utilisés aujourd’hui, tels que BERT et GPT-3. Initialement développés pour des cas d’utilisation du traitement du langage naturel, leur polyvalence est de plus en plus appliquée à la vision par ordinateur, à la découverte de médicaments, etc., comme nous l’avons documenté dans notre État de la couverture de l’IA. Selon une métrique partagée par NVIDIA, 70 % des recherches publiées sur l’IA au cours des 2 dernières années sont basées sur les transformateurs.

Le côté logiciel : bonne nouvelle pour les utilisateurs d’Apache Spark

Mais qu’en est-il du côté logiciel ? Dans les annonces précédentes de GTC, les mises à jour de la pile logicielle constituaient un élément clé de l’actualité. Dans ce cas, alors que les heuristiques optimisées par NVIDIA qui choisissent dynamiquement entre les calculs FP8 et FP16 constituent un élément clé du nouveau moteur de transformateur en interne, les mises à jour de la pile logicielle externe semblent moins importantes en comparaison.

Triton Inference Server de NVIDIA et framework NeMo Megatron pour la formation de grands modèles de langage reçoivent des mises à jour. Il en va de même pour Riva, Merlin et Maxin : un SDK d’IA vocale qui comprend respectivement des modèles pré-entraînés, un cadre d’IA de recommandation de bout en bout et un SDK d’amélioration de la qualité audio et vidéo. Comme NVIDIA l’a souligné, ceux-ci sont utilisés par AT&T, Microsoft et Snapchat.

Il existe également 60 mises à jour du SDK pour les bibliothèques CUDA-X de NVIDIA. NVIDIA a choisi de mettre en avant les domaines émergents tels que l’accélération de la simulation de circuits quantiques (disponibilité générale de cuQuantum) et la recherche sur la couche physique 6G (disponibilité générale de Sionna). Cependant, pour la plupart des utilisateurs, la bonne nouvelle réside probablement dans mise à jour dans l’accélérateur RAPIDS pour Apache Sparkce qui accélère le traitement de plus de 3 fois sans aucune modification de code.

Même si cela n’était pas vraiment important dans les annonces de NVIDIA, nous pensons que cela devrait l’être. Une accélération 3x du jour au lendemain sans modification du code pour les utilisateurs d’Apache Spark, avec 80 % des entreprises Fortune 500 utilisant Apache Spark en production, n’est pas une mince nouvelle. Ce n’est pas la première fois NVIDIA montre aux utilisateurs d’Apache Spark qu’ils aiment non plus.

Dans l’ensemble, NVIDIA semble maintenir sa dynamique. Même si la concurrence est rude, avec le une longueur d’avance NVIDIA a réussi à créerdes refontes radicales ne sont peut-être pas vraiment nécessaires.